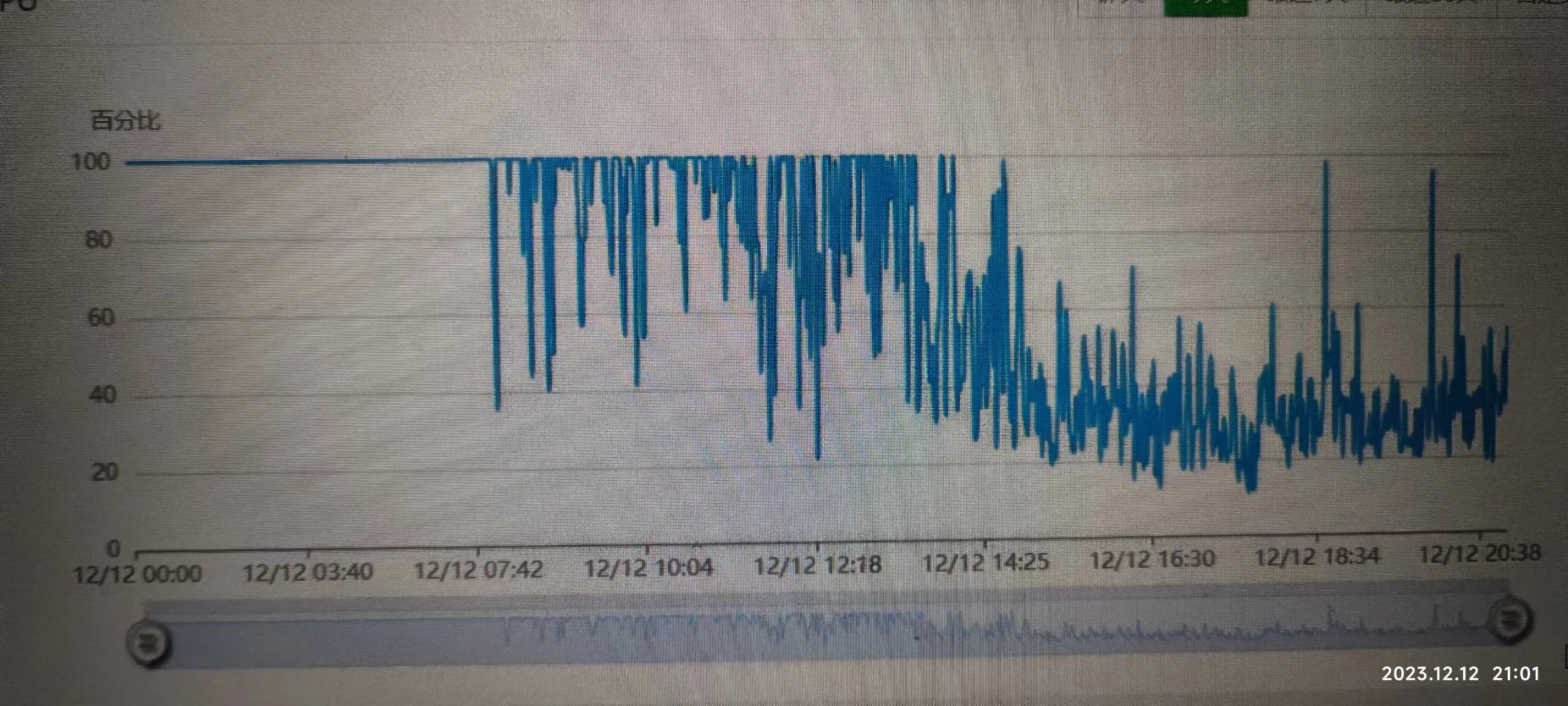

早上起来送丸子上学,收到了server酱通知,Mysql服务连接过多,一脸蒙B,新上的服务器,3核CPU,平常负载才不到30%,还有很大的余量,难不成被大V推荐,流量蜂拥而来,一查服务器,CPU彪满了飘红了,但是并非正常的用户,因为广告费明显没有增加,因为要送丸子上学,只简单mysql restart了一下。

10分钟不到再看,mysql竟然还没有重启,卡得死死的。因为服务器运行了几个容器,一个个排查,最后发现,竟然是semrush爬虫导致的,最近流量下跌的厉害,想着写写博客,注册了semrush想研究下,没想到半夜开始疯狂爬我的数据,我所有页面其实都有做redis缓存,再大的流量都不怕,唯一有一个分页面,有600W的数据,semrush疯狂抓这个页面的数据,虽然我做了86400秒的缓存,但是还是架不住数据量太大,Limit = 20,600W数据也有30W个页面,这哪扛得住。

好在semrush爬虫识别度很高,直接封了User-Agent简单解决了问题。

以前爬别人的数据,现在被别人爬😂。

最近流量爆跌,我也分析了很多排在前面的同行页面,他们其实并不是靠大量页面,大量关键字排上去的,有可能在长尾关键字上会贡献不多的流量,我感觉做再多的分页没有太大的用处,有可能反而还会有弊端,这次过后,会慢慢精简一下页面,然后重点开始做内容,以前流量来得太容易,感觉seo没啥难的,轻轻松松能排到第一页,自从谷歌秋季更新后,这种轻松的感觉瞬间消失,反而变得焦虑起来了。

爬人者,人恒爬之🤣

看来兄台经验比较丰富😂